DeepSeek真算是給大模型圈提了個速——

就在剛剛,OpenAI深夜緊急發布了最新推理模型,o3-mini系列。

一共包含三個版本:low、medium和high。

其中o3-mini和o3-mini-high已經上線:

根據官方口徑,o3系列模型,目標是推動低成本推理的邊界。

ChatGPT Plus、團隊和Pro用戶從今天起可以訪問OpenAI o3-mini,企業級訪問將在一周后開放。

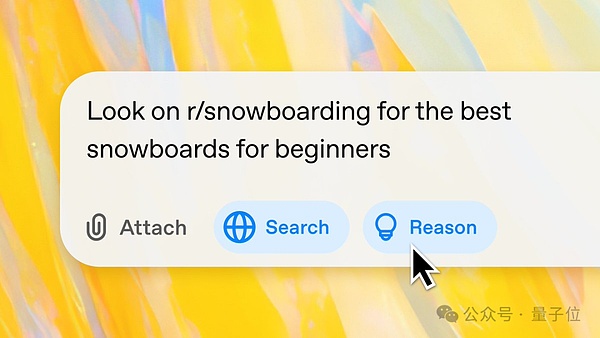

免費用戶也可以通過選擇“Search+Reason”來使用o3-mini來體驗搜索。

或許是被DeepSeek逼急了,這是OpenAI首次向用戶免費推出的推理模型。

甚至在隨后的Reddit“有問必答”活動中,CEO奧特曼也罕見公開反思:

在開源權重AI模型這個問題上,(個人認為)我們站在了歷史錯誤的一邊。

與此同時,短短數小時內,網友們已經開始瘋狂實測ing……

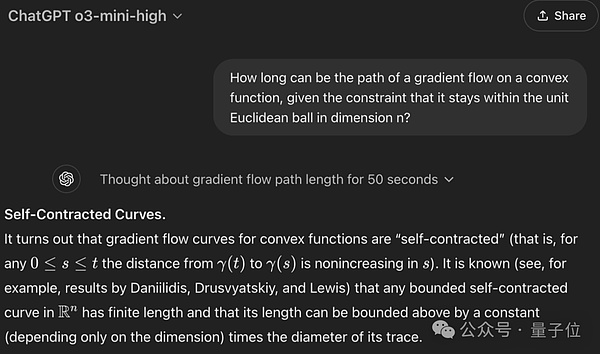

還是先來看看技術報告都寫了啥。

去年年底,OpenAI上線了o3-mini預覽版,再次刷新小模型能力邊界。(在成本和低延遲上與o1-mini相當)

當時CEO奧特曼預告稱,正式版將在今年1月發布。而卡在ddl的最后時刻,正式版o3-mini終于上桌。

整體而言,和前一代o1-mini類似,它也針對STEM(Science、Technology、Engineering、Mathematics)進行了優化,延續了mini系列小而美的風格。

僅o3-mini(medium),不但在數學編碼上的表現與o1系列相當,而且響應更快。

人類專家測評顯示,大多數情況下o3-mini比o1-mini產生更準確、更清晰的答案,獲得了56%的偏好度,同時在處理復雜現實問題時的重大錯誤率更是降低了39%。

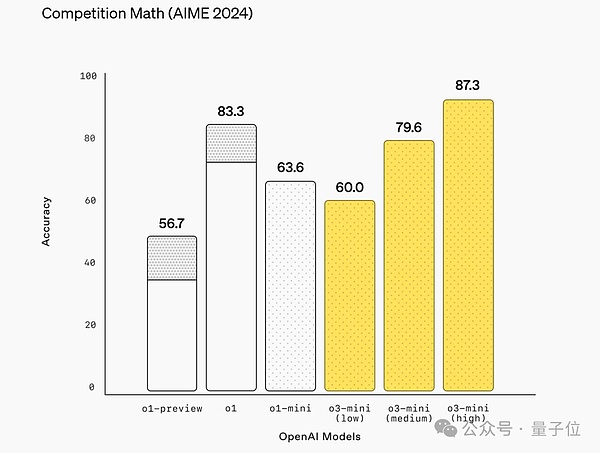

數學能力上,低推理強度下的o3-mini(low)達到了與o1-mini相當的水平;中等推理強度下能力媲美滿血版o1;而一旦推理強度拉滿(high),其表現直接超越o1系列一眾模型。

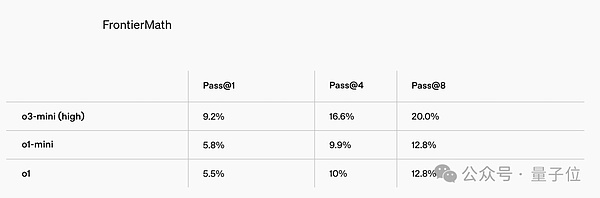

在由60多位頂尖數學家準備的FrontierMath難題測試中,高推理強度下的o3-mini相較o1系列也有了大幅提升。

官方甚至特意注明,如果搭配Python工具使用,o3-mini(high)在第一次嘗試時就解決了超過32%的問題,其中包括28%以上的T3級問題。

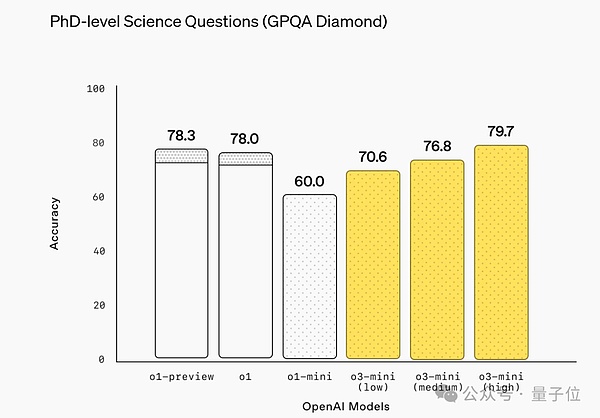

科學能力方面,在PhD水平的物化生問題上,低推理強度下的o3-mini就已經和o1-mini拉開了層級。

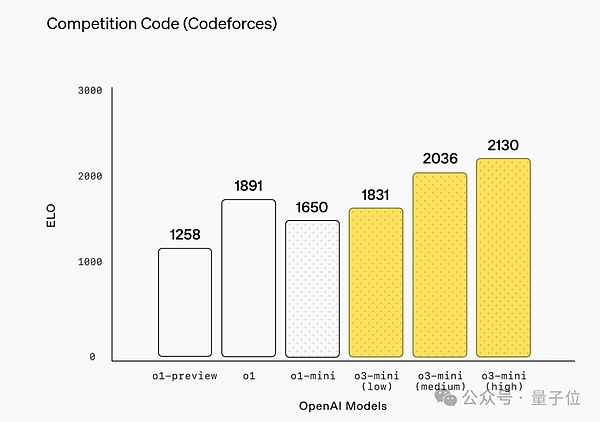

當然,在編碼這項重要能力上,o3-mini更是在各層級上領先o1系列。

根據它們在LiveBench的表現可以看出,隨著推理強度升級,o3-mini的優勢還在不斷擴大。

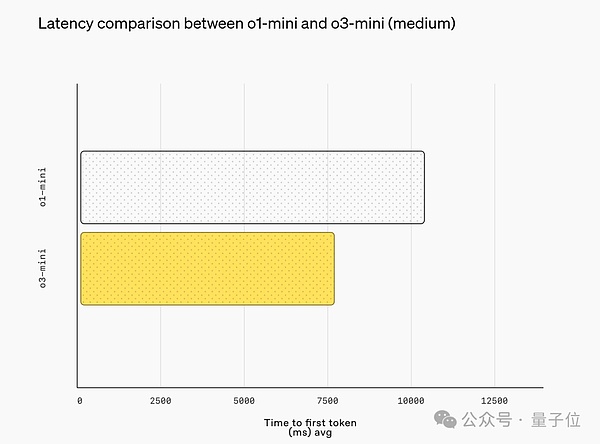

而且需要提醒,o3-mini在取得上述領先的同時響應更快,其平均響應時間為7.7秒,較o1-mini的10.16秒提升了24%。

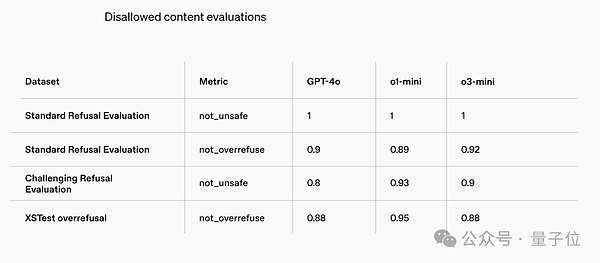

最后在安全評估方面,o3-mini在多項安全評估中明顯超過了GPT-4o。

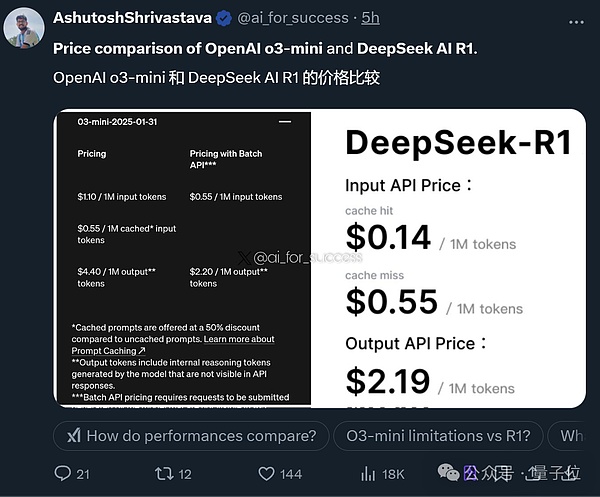

價格方面,相比于輸入/輸出分別為0.14/0.55美元的DeepSeek-R1,o3-mini依舊貴出天際。

根據網友辣評,DeepSeek-R1目前還是性價比之王:更快、更好、更便宜。

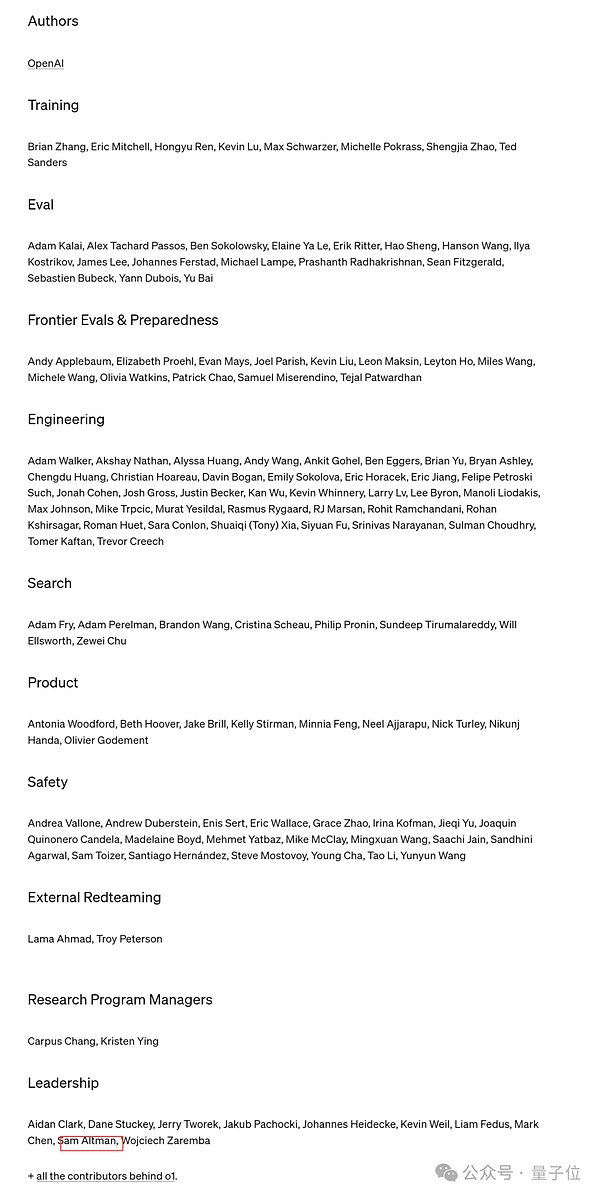

BTW,OpenAI此次照例公布了o3-mini背后團隊。可以看出,這一次是由奧特曼本人親自帶隊,研究項目主管分別為Carpus Chang和Kristen Ying(名單中也有很多我們熟悉的老朋友如任鴻宇、趙盛佳等)。

正如我們剛才所提到的,目前網友們已經開始瘋狂實測中。

不過從評價上來看,大伙兒對o3-mini的表現褒貶不一。

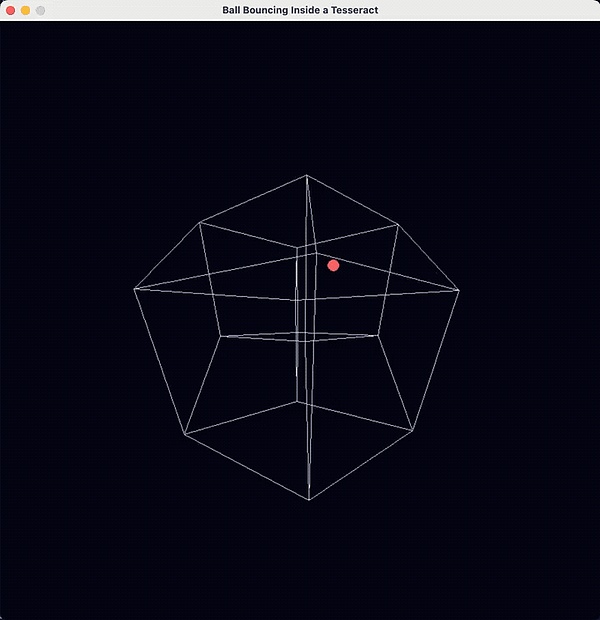

例如在用Python實現“球在四維體內部彈跳”的任務上,有人認為o3-mini是最好的LLM:

效果是這樣的:

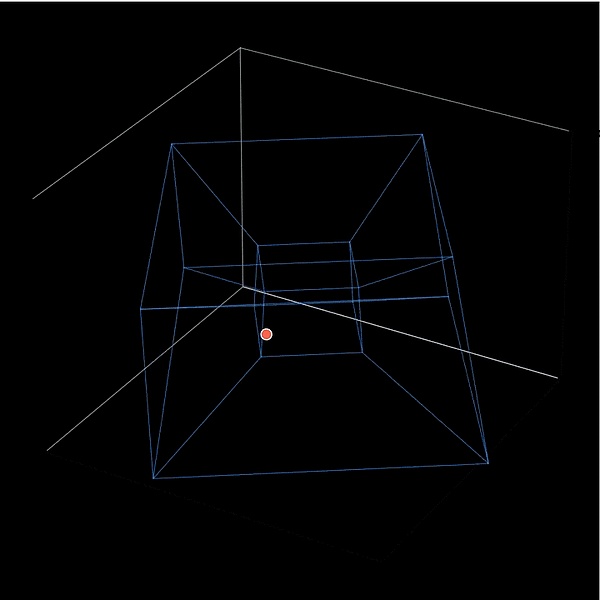

然后有網友嘗試用DeepSeek來做同樣的任務,從效果上來看,認為o3-mini稍微勝出一些:

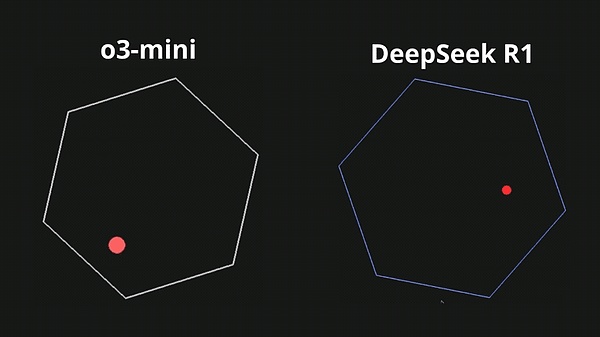

更直接的對比,讓一個球在旋轉的六邊形內彈跳,球應受到重力和摩擦力的影響,o3-mini和DeepSeek R1的效果差距就比較明顯了:

包括更復雜的一些的任務,在球體內創建100個彈跳的黃色球,o3-mini現在也是可以做到:

再如讓o3-mini設計兩個貪吃蛇互相競爭的游戲:

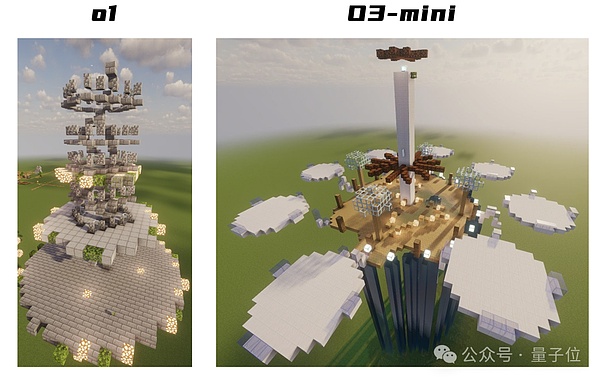

除了DeepSeek之外,網友也用o1和o3-mini的效果做了對比,例如生成一座龐大、驚人的史詩級漂浮城市。

還有一位網友提出了令幾乎所有大模型都會出錯的迷惑性題目,但讓他較為震驚的是,o3-mini竟然答對了:

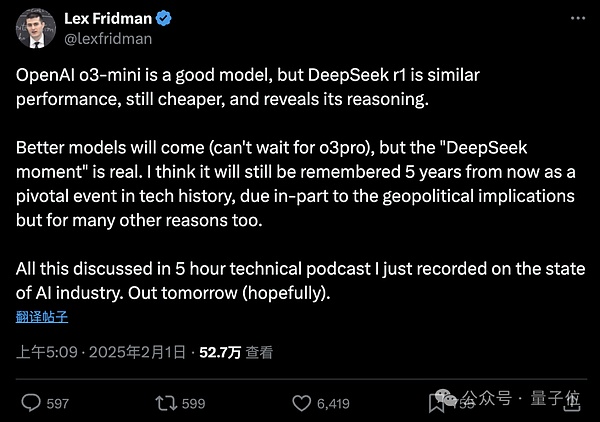

不過知名播客博主Lex Fridman對o3-mini的評價卻是:

OpenAI o3-mini是一個好模型,但DeepSeek R1性能相似,價格更低,并揭示了其推理過程。

更好的模型將會出現(迫不及待想要 o3-pro),但“DeepSeek 時刻”是真實的。我認為五年后它仍會被記住,作為科技歷史上的一個轉折點。

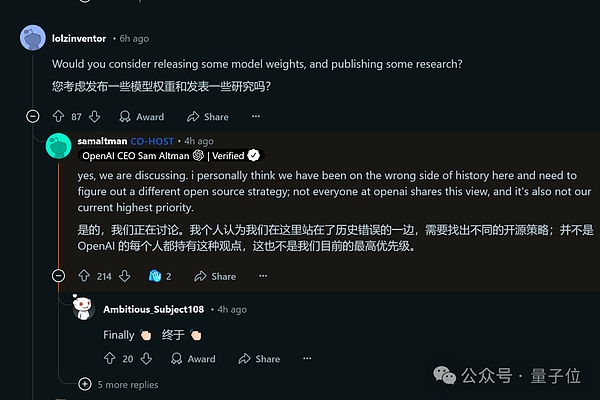

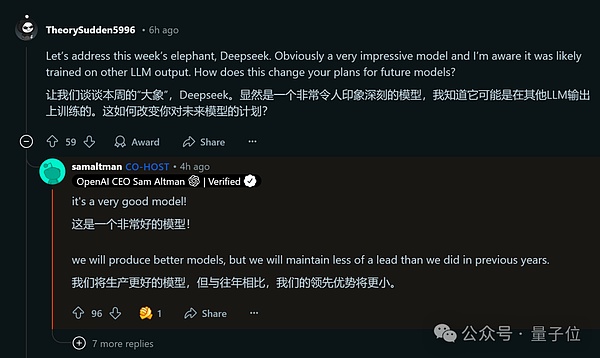

就在o3-mini上線幾小時后,奧特曼本人也攜團隊參與了Reddit的“有問必答”活動。

考慮到開源DeepSeek最近攪動了AI圈,奧特曼罕見公開反思:

在開源權重AI模型這個問題上,(個人認為)我們站在了歷史錯誤的一邊。

甚至也承認,OpenAI的領先優勢不會像以前那么大了。

DeepSeek的確很優秀,我們也會繼續研發更好的模型,但領先優勢將更小。

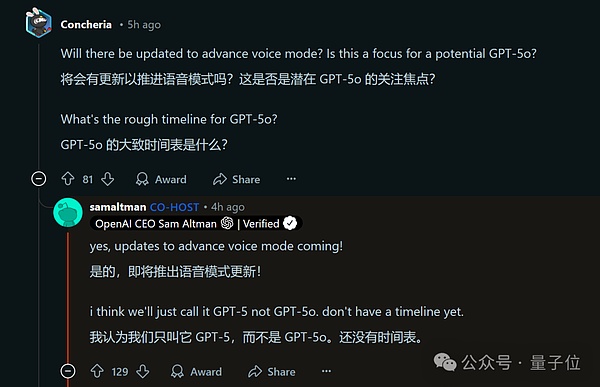

與此同時,OpenAI的一些未來計劃也曝光了。

比如高級語音模式即將迎來更新,OpenAI會直接稱它為GPT-5,而不是GPT-5o,不過目前還沒有具體時間表。

另外,推理模型也將支持調用更多工具。

最后,滿血版o3也被提及,不過看起來距離還相當遙遠……